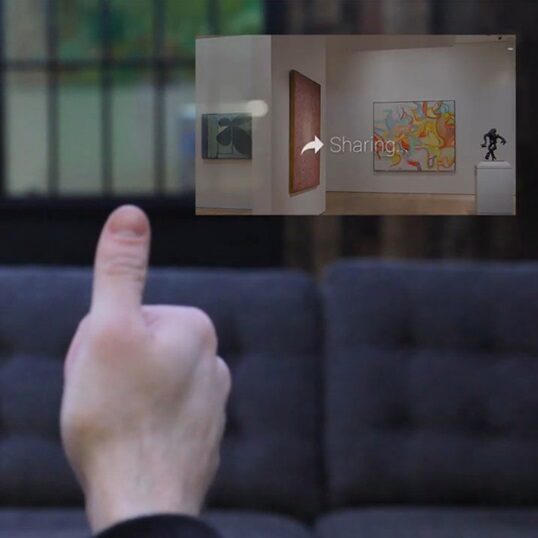

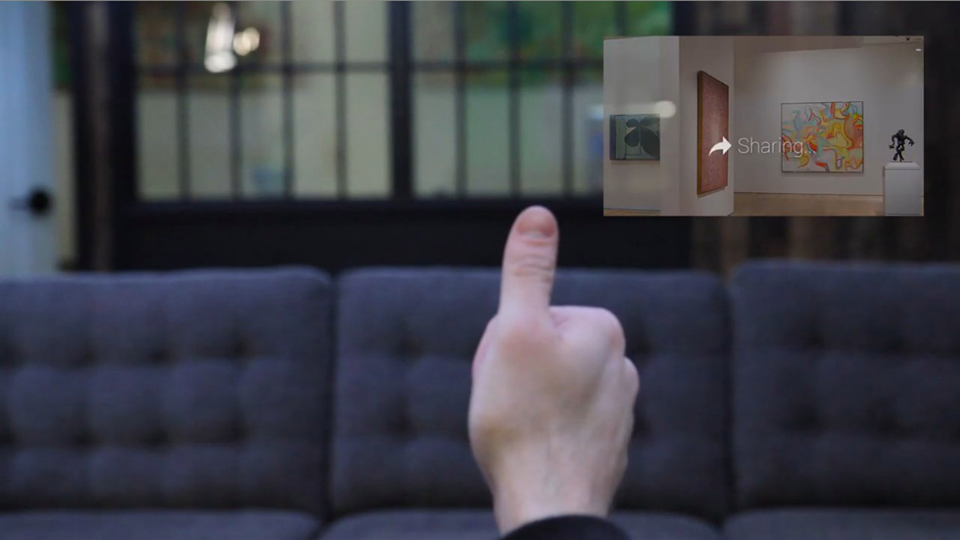

Google Glass to narzędzie, które sterowane jest na trzy sposoby: ruchem głowy, głosowo oraz przez dotykowy panel na obudowie. Możemy doliczyć do nich jeszcze mruganie okiem, ale nie wszystko da się zrobić tą drogą. Inteligentne okulary mogą być jeszcze bardziej smart, a to za sprawą zaimplementowania w ich oprogramowaniu funkcji rozpoznawania obrazu. Konkretnie gestów rąk, które miałyby wspomóc nas w kontroli treści, ale i w sterowaniu funkcjami Google Glass. To właśnie kamerka jest najważniejszą częścią projektu, gdyż umożliwi obserwacje dłoni.

To kolejny z potencjałów jakie drzemią w gadżecie Google. Spróbuje wykorzystać go pewne studio, które nazwało swoją nową platformę „OnTheGo”. Chcą przekonać, że proste gesty będzie można praktycznie wykorzystać do tworzenia kontaktów, przesuwania kart, wywoływania migawki aparatu, czy chociażby do gier. Poszczególnym gestom można nadać wiele ról. Myślę, że mogą przydać się w niektórych sytuacjach, a należy wziąć pod uwagę, że system jest w fazie rozwoju. Z czasem może znaleźć całe mnóstwo zastosowań.

Developer przygotował narzędzia SDK, a te mogą zostać wykorzystane przez programistów i jeszcze bardziej rozszerzyć możliwości urządzenia Google. Taki sposób obsługi Glass jest całkiem naturalny, ale będzie wymagał kierowania wzroku (kamerki) na ręce lub podnosić je dosyć wysoko przed siebie, aby gesty mogły być odczytane. Na poniższym materiale video widać demonstrację kilku z nich, w tym zabawę w ciachanie owoców we Fruit Ninja. Platforma przewiduje wykorzystanie narzędzi także na innych inteligentnych okularach z Androidem (np. Vuzix M100).