Google Lens to część nowych możliwości algorytmów Sztucznej Inteligencji z Mountain View. Projekt zintegrowano z Google Photos i Google Asystentem, by poprzez widzenie komputerowe można było wykorzystać nowe możliwości smart oprogramowania. Niebawem rozwiązanie trafi do aplikacji aparatu, więc nie będziemy musieli nawet zapisywać fotek, by skorzystać z narzędzi rozpoznających obiekty. Na zeszłotygodniowym Google I/O zaprezentowano nowe funkcje, których nauczono system Google Lens. Jak praktycznie na tym skorzystamy?

Niedługo asystenta głosowego wesprze ten wizualny, a razem zdziałać mają jeszcze więcej. Nasze telefony będą potrafiły nowe rzeczy, a wszystko poprzez pomoc AI, czyli softu przetwarzającego dane w nowy sposób. Wsparcie kolejnych opcji ma przyspieszyć nasze działania, które obecnie nie nadążają za rozrostem multitaskingu. Część zadań już teraz można zlecać komendami, ale pora na pomoc kamerki, której obiektyw sprzęgnięty z algorytmami może dać dodatkowe efekty. Google powoli, ale sukcesywnie rozwija projekt Lens. Docelowo ma być z czasem nawet ważniejszy od asysty głosowej.

Pierwsze możliwości oparto na pomocy w rozpoznawaniu widoku, dzięki czemu użytkownik otrzymywał informacje na jego temat. Już samo to ma w sobie ogromny potencjał, ale trzeba czasu, by developerzy i autorzy programu zaproponowali prawdziwie użyteczne funkcje (przede wszystkim przez ich integrację w aplikacjach sklepów, map, serwisów itp.). Identyfikacja obrazu w czasie rzeczywistym przez smartfonowy aparat ma co zaoferować. Te nowe możliwości zaprezentowano na konferencjach developerskich, dając programistom podgląd w to, co aplikacja może zdziałać.

From traffic signs to business cards to restaurant menus, words are everywhere. Now, with smart text selection, Google Lens can connect the words you see with the answers and actions you need. #io18 pic.twitter.com/NB4Ima4is4

— Google (@Google) 8 maja 2018

Fajnym przykładem jest tu trick zwany smart text selection, czyli kopiowanie tekstu z realnego świata do tego cyfrowego. Przez kamerkę można zaznaczyć widziany tekst i bez jego ręcznego przepisywania wkleić np. do wyszukiwarki lub notatnika. Przypuszczam, że ułatwi to też proces wyszukiwania haseł w przeglądarce Google. Już sam podgląd tekstu może kontekstowo doradzić nam na ekranie telefonu bardziej szczegółowe dane i to niekoniecznie od autora napisów. Nie jesteś pewien co zawiera danie proponowane w menu? Telefon może pomóc ocenić kaloryczność, zawartość treści itd. Naprawdę jest tu bardzo dużo możliwości. To jak wyszukiwanie obrazem, ale z dodatkowym przekazem.

In a few weeks, a new Google Lens feature called style match will help you look up visually similar furniture and clothing, so you can find a look you like. #io18 pic.twitter.com/mH4HFFZLwH

— Google (@Google) 8 maja 2018

Jedną z ciekawszych funkcji będzie moim zdaniem style match. To właśnie jest wspomniane wyżej ulepszenie dla wyszukiwarki obrazem. Wystarczy skierować kamerkę na dany obiekt, by przejrzeć sklepy i sieć pod kątem podobnych (a najlepiej dokładnie takich samych) produktów. Łatwo wyobrazić sobie ile nowych przedmiotów można w ten sposób znaleźć i oczywiście kupić. Coś w tym stylu ma już chyba eBay w ramach rozwiązań Rzeczywistości Rozszerzonej (Find It On eBay).

And Lens will soon work in real time. By proactively surfacing results and anchoring them to the things you see, you’ll be able to browse the world around you, just by pointing your camera → https://t.co/A1nUSk8zsK #io18 pic.twitter.com/0xNI4dZez8

— Google (@Google) 8 maja 2018

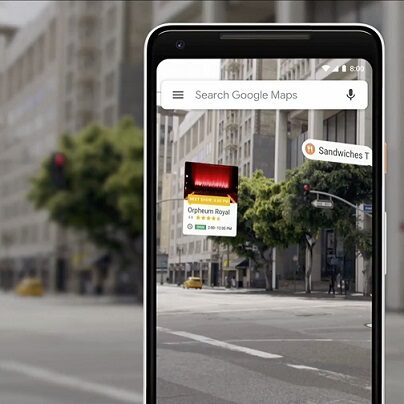

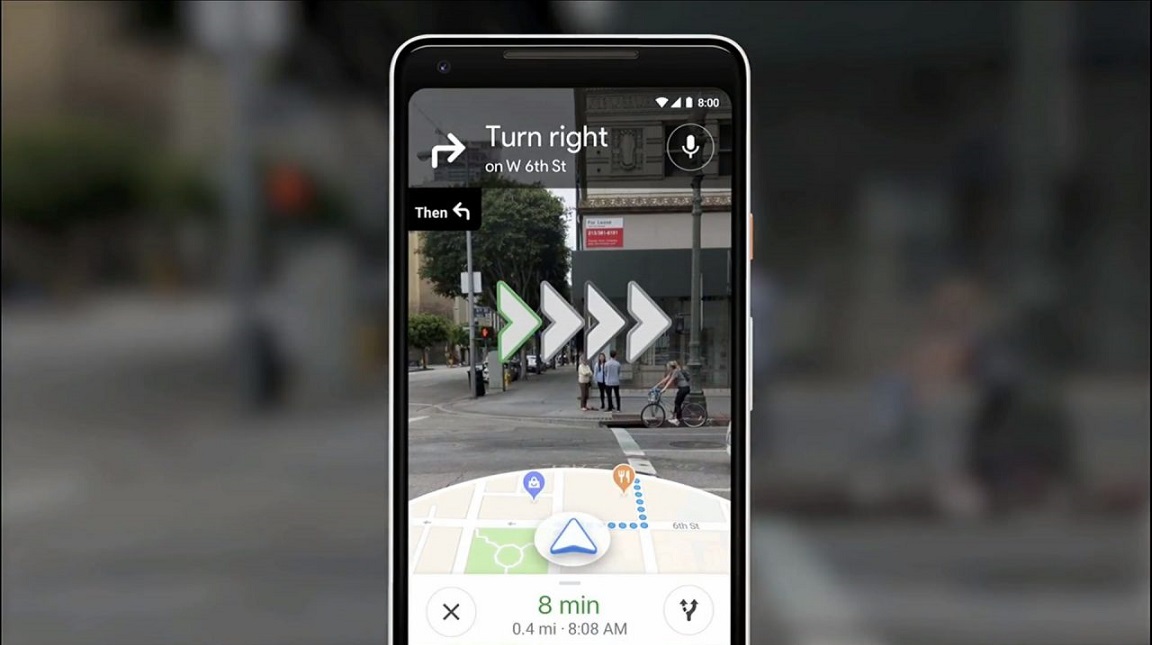

Nie zabraknie też integracji Google Lens z innymi serwisami Google. Ich poprawiane przez nowe narzędzia to wręcz konieczność. Google proponuje Lens dla Google Maps, czyli podgląd wskazówek w czasie rzeczywistym w widoku street view. Wystarczyć ma skierowanie kamerki na kadr lokalizacji, by otrzymać wsparcie przewodnika, pomocy oznakowania i przydatnych informacji na temat atrakcji danej miejscowości (także restauracji i hoteli). To wszystko to tylko drobne próbki, ale demonstrujące moc nowej aplikacji. Już w smartfonie będzie wartościową pomocą, ale wyobrażam sobie, że docelowo sprawdzi się najlepiej w smart okularach. Na te naprawdę dobre jeszcze czekamy.